Article 3. 데이터 분석 방안 1213

Section 1. 분석 방안 수립

Paragraph 1. 빅데이터 분석 방법론 개념

- 빅데이터를 분석하기 위해 문제를 정의하고 답을 도출하기 위한 체계적인 절차와 처리 방법이다

- 데이터 분석 방법론의 구성요소에는 절차, 방법, 도구와 기법, 템플릿과 산출물이 있다

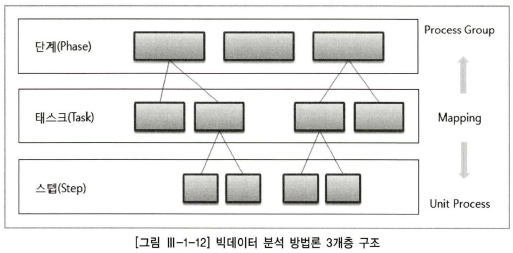

Paragraph 2. 빅데이터 분석 방법론 계층

- 빅데이터 분석 방법론 계층은 단계, 태스크, 스텝으로 구성되어 있다

-

단계(Phase)

프로세스 그룹을 통하여 완성된 단계별 산출물이 생성, 기준선으로 설정 관리하며, 버전 관리 등을 통한 통제

-

태스크(Task)

단계를 구성하는 단위 활동, 물리적 또는 논리적 단위로 품질 검토의 항목이 될 수 있음

-

스템(Step)

입력자료(Input), 처리 및 도구(Process & Tool), 출력자료(Output)로 구성된 단위 프로세스(Unit Process)

Paragraph 3. 빅데이터 분석 방법론의 분석 절차

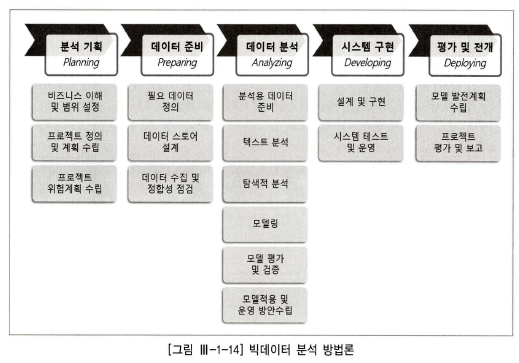

- 분석 기획

- 비즈니스 이해 및 범위 설정

- 프로젝트 진행을 위해 비즈니스에 대한 충분한 이해와 도메인 문제점 파악

- 업무 매뉴얼 및 업무 전문가 도움 필요, 구조화된 명세서 작성

- 프로젝트 정의 및 계획 수립

- 모델의 운영 이미지를 설계하고 모델 평가 기준을 설정, 프로젝트의 정의를 명확하게 함

- WBS를 만들고 데이터 확보계획, 빅데이터 분석 방법, 일정계획, 예산 계획, 품질계획, 인력구성계획, 의사소통계획 등을 포함하는 프로젝트 수행 계획을 작성

- 프로젝트 위험계획 수립

- 발생 가능한 모든 위험을 발굴하여 사전에 대응 방안을 수립함으로써 프로젝트 진행의 완전성을 높임

- 위험대응 방법에는 회피(Avoid), 전가(Transfer), 완화(Mitigate), 수용(Accept)이 있음

- 비즈니스 이해 및 범위 설정

- 데이터 준비(Preparing)

- 필요 데이터 정의

- 정형/비정형/반정형 등의 모든 내/외부 데이터와 데이터 속성, 오너, 담당자 등을 포함하는 데이터 정의서 작성

- 구체적인 데이터 획득 방안을 상세하게 수립하여 프로젝트 지연 방지

- 데이터 스토어 설계

- 획득 방안이 수립되면 전사 차원의 데이터 스토어 설계

- 데이터 수집 및 정합성 검증

- 데이터 스토어에 크롤링, 실시간 처리, 배치 처리 등으로 데이터 수집

- 데이터베이스 간 연동, API를 이용한 개발, ETL 도구의 활용 등 수집 프로세스 진행

- 필요 데이터 정의

- 데이터 분석

- 분석용 데이터 준비

- 비즈니스 룰 확인(비즈니스 이해, 도메인 문제점 인식, 프로젝트 정의 등을 통해 프로젝트 목표 정확히 인식)

- 분석용 데이터셋 준비(데이터 스토어로부터 분석에 필요한 정형, 비정형 데이터 추출)

- 텍스트 분석

- 어휘/구분 분석(Word Analysis), 감성 분석(Sentimental Analysis), 토픽 분석(Topic Analysis), 오피니언 분석(Opinion Analysis), 소셜 네트워크 분석(SNA; Social Network Analysis)

- 탐색적 분석(EDA)

- 기초 통계량 산출, 데이터 분포와 변수 간의 관계 파악, 데이터 시각화

- 모델링

- 훈련용 데이터 세트와 테스트용 데이터 세트로 분리하여 과적합 방지(데이터 분할)

- 데이터 모델링

- 모델에 대한 상세한 알고리즘 작성(모델 적용 및 운영 방안)

- 모델 평가 및 검증

- 데스트 데이터 세트를 이용하여 모델 검증 작업 실시, 보고서 작성

- 모델 적용 및 운영 방안수립

- 검증된 모델을 적용하고 최적화하여 운영할 수 있는 방안 수립

- 분석용 데이터 준비

- 시스템 구현

- 설계 및 구현

- 모델링 태스크에서 작성된 알고리즘 설명서와 데이터 시각화 보고서를 이용하여 시스템 및 데이터 아키텍처 설계, 사용자 인터페이스 설계를 진행

- 설계서를 바탕으로 패키지를 활용하거나 새롭게 프로그램을 코딩하여 구축

- 시스템 테스트 및 운영

- 단위 테스트, 통합 테스트, 시스템 테스트 실시

- 설계 및 구현

- 평가 및 전개

- 모델 발전 계획 수립

- 모델의 생명주기를 설정, 주기적인 평가를 실시하여 유지보수하거나 재구축 방안 마련

- 모델의 특성을 고려하여 모델 업데이트를 자동화하는 방안 수립 적용 가능

- 프로젝트 평가 보고

- 기획 단계에서 설정된 기준에 따라 프로젝트의 성과를 정량적, 정성적 평가하고 프로젝트 진행 과정에서 지식, 프로세스, 출력자료를 지식 자산화하고 프로젝트 최종 보고서를 작성한 후 의사소통계획에 따라 프로젝트 종료

- 모델 발전 계획 수립

Paragraph 4. 분석 방법론 유형

Subparagraph 1. KDD 분석 방법론

Clause 1. KDD(Knowledge Discovery in Databases) 분석 방법론 개념

1996년 Fayyad가 프로파일링 기술을 기반으로 통계적 패턴이나 지식을 찾기 위해 체계적으로 정리한 방법론이다

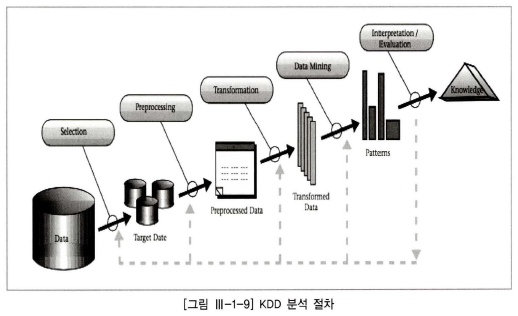

Clause 2. KDD 분석 방법론의 분석 절차

- KDD 분석 방법론의 분석 절차는 데이터 세트 선택, 데이터 전처리, 데이터 변환, 데이터 마이닝, 데이터 마이닝 결과 평가 5개 단계이다

- 데이터로부터 목표 데이터(Target Data), 전처리 데이터(Preprocessed Data), 변환 데이터(Transformed Data), 패턴(Patterns)을 통해 지식(Knowledge)을 생성한다

- 데이터 세트 선택

- 분석 대상의 비즈니스 도메인에 대한 이해와 프로젝트의 목표 설정

- 데이터베이스 또는 원시 데이터에서 선택 혹은 추가적으로 생성

- 데이터 마이닝에 필요한 목표 데이터(Target Data) 구성

- 데이터 전처리

- 노이즈, 이상값, 결측값 등을 제거

- 추가로 요구되는 데이터 세트가 있을 경우 데이터 세트 선택, 프로세스 재실행

- 데이터 변환

- 변수를 찾고, 데이터 차원 축소

- 데이터 마이닝 효율적으로 적용될 수 있도록 데이터 세트로 변경

- 데이터 마이닝

- 분석 목적에 맞는 데이터 마이닝 기법, 알고리즘 선택, 패턴 찾기, 데이터 분류, 예측작업

- 필요에 따라 데이터 전처리, 변환 프로세스 병행 가능

- 데이터 마이닝 결과 평가(Interpretation/Evaluation)

- 분석 결과에 대한 해석/평가, 발견된 지식 활용

- 필요시 선택부터 마이닝까지 프로세스 반복 수행

Subparagraph 2. CRISP-DM 분석 방법론

Clause 1. CRISP-DM(Cross Industry Standard Process for Data Mining) 분석 방법론의 개념

- 비즈니스의 이해를 바탕으로 데이터 분석 목적의 6단계로 진행되는 데이터 마이닝 방법론이다

- 1996년 유럽연합의 ESPRIT 프로젝트에서 시작한 방법론으로 1997년 SPSS 등이 참여하였으나 현재에는 중단되었다

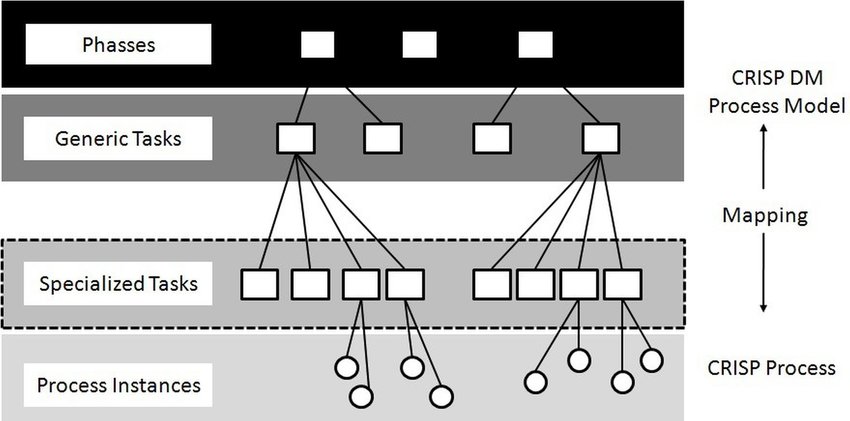

Clause 2. CRISP-DM 분석 방법론의 구성

-

단계(Phase)

- 최상위 레벨

-

일반화 태스크(Generic Task)

- 데이터 마이닝의 단일 프로세스를 완전하게 수행하는 단위

- 각 단계는 일반화 태스크 포함

-

세분화 태스크(Specialized Tasks)

-

일반화 태스크를 구체적으로 수행하는 레벨

데이터 정제의 일반화 태스크는 범주형, 연속형 데이터 정제 등으로 구체화된 세분화 태스크

-

-

프로세스 실행(Process Instances)

- 데이터 마이닝을 위한 구체적인 실행

Clause 3. CRISP-DM 분석 방법론의 분석 절차

- 단계 간 피드백을 통하여 단계별 완성도를 높인다

- 업무 이해(Business Understanding)

- 각종 참고 자료와 현업 책임자와의 커뮤니케이션을 통해 비즈니스를 이해하는 단계

- 업무 목적 파악, 상황 파악, 데이터 마이닝 목표 설정, 프로젝트 계획 수립

- 데이터 이해(Data Understanding)

- 분석을 위한 데이터를 수집 및 속성을 이해하고, 문제점을 식별하며 숨겨져 있는 인사이트를 발견하는 단계

- 초기 데이터 수집, 데이터 기술 분석, 데이터 탐색, 데이터 품질 확인

- 데이터 준비(Data Preparation)

- 데이터 정제, 새로운 데이터 생성 등 자료를 분석 가능한 상태로 만드는 단계

- 데이터 준비에 많은 시간이 소요

- 분석용 데이터 세트 선택, 데이터 정제, 데이터 통합, 학습/검증 데이터 분리 등 수행

- 모델링(Modeling)

- 다양한 모델링 기법과 알고리즘을 선택하고 파라미터를 최적화하는 단계

- 모델링 기법 선택, 모델 테스트 계획 설계, 모델 작성, 모델 평가를 수행함

- 평가(Evaluation)

- 데이터 정제, 새로운 데이터 생성 등 자료를 분석 가능한 상태로 만드는 단계

- 평가에 많은 시간이 소요

- 분석 결과 평가, 모델링 과정 평가, 모델 적용성 평가를 수행

- 전개(Deployment)

- 데이터 정제, 새로운 데이터 생성 등 자료를 분석 가능한 상태로 만드는 단계

- 전개에 많은 시간이 소요

- 전개 계획 수립, 모니터링과 유지보수 계획 수립, 프로젝트 종료 보고서 작성, 프로젝트 리뷰

Subparagraph 3. SEMMA 분석 방법론

Clause 1. SEMMA(Sampling Exploration Modification Modeling Assessment) 분석 방법론 개념

분석 솔루션 업체 SAS사가 주도한 통계 줌심의 5단계(샘플링 ➔ 탐색 ➔ 수정 ➔ 모델링 ➔ 검증) 방법론이다.

Clause 2. SEMMA 분석 방법론의 분석 절차

SEMMA 분석 방법론의 분석 절차는 샘플링, 탐색, 수정, 모델링, 검증의 5단계로 되어 있다

- 샘플링(Sampling)

- 통계적 추출, 조건 추출을 통한 분석 데이터 생성

- 비용 절감 및 모델 평가를 위한 데이터 준비

- 탐색(Exploration)

- 기초통계, 그래프 탐색, 요인별 분할표, 클러스터링, 변수 유의성 및 상관분석을 통한 분석 데이터 탐색

- 데이터 조감을 통한 데이터 오류 검색

- 모델의 효율 증대

- 데이터 현황을 통해 비즈니스 이해, 아이디어를 위해 이상현상, 변화 등을 탐색

- 수정(Modification)

- 수량화, 표준화, 각종 변환, 그룹화를 통한 분석 데이터 수정/변환

- 데이터가 지닌 정보의 표현 극대화

- 최적의 모델을 구축할 수 있도록 다양한 형태로 변수를 생성, 선택, 변형

- 모델링(Modeling)

- 신경망, 의사결정나무, 로지스틱 회귀 분석, 전통적 통계를 이용한 모델 구축

- 데이터의 숨겨진 패턴 발견

- 하나의 비즈니스 문제 해결을 위해 특수한 모델과 알고리즘 적용 가능

- 검증(Assessment)

- 모델 평가 검증

- 서로 다른 모델을 동시에 비교

- 추가 분석 수행 여부 결정